728x90

반응형

SMALL

Fleiss's Kappa

모델에서 라벨링 후 데이터의 품질을 확인하기 위해 작업자 간에 라벨링을 얼마나 비슷한 기준으로 했는지를 평가하는 방법이 작업자간 일치도 (IAA)평가이다. IAA의 대표적인 방법으로는 Kappa 계수와 Krippendorff's α (KLUE)가 존재한다.

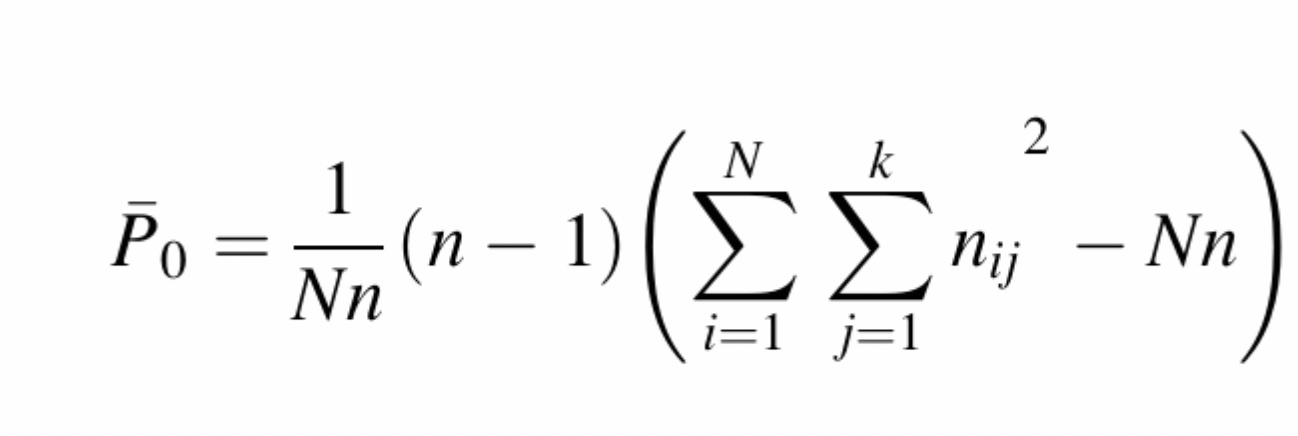

Cohen's Kappa 계수는 두 개의 관찰자가 있는 경우에만 사용된다. 비교 중인 이진 변수에 대해 2개 이상의 관찰자가 있거나 2개 이상의 범주가 있는 경우 "Fleiss Kappa 계수"라고 하는 또 다른 일치 측도를 계산해야 한다. 계수는 관측치의 등급 단위에서 전반적인 일관성을 나타내는 측도이다. 전체 Kappa 공식은 Cohen's Kappa와 동일하지만 p0와 pe는 다르게 계산된다.

여기서 N은 대상의 총 개수, n은 대상당 평점의 개수, k는 카테고리의 개수이다. i는 대상의 인덱스, j는 카테고리의 인덱스를 나타낸다. 따라서, nij는 j번째 카테고리에 i번째 대상에 할당한 관찰자의 개수이다.

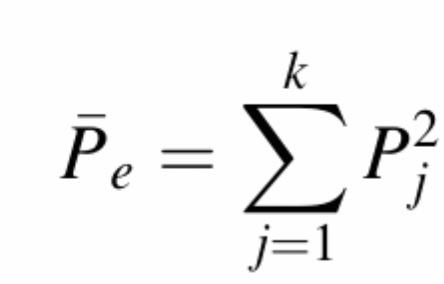

여기서 Pj는 j번째 범주에 할당된 모든 관측치 (n / N)의 비율이다 (ex: 열 합계를 모든 관측치로 나눈 값). Fleiss의 Kappa 계수에 대한 해석은 Cohen의 계수와 같다.

from statsmodels.stats import inter_rater as irr

agg = irr.aggregate_raters(arr) # arr is the array of ratings

kappa = irr.fleiss_kappa(agg[0]) # agg[0] is the table of subjects and categories728x90

반응형

LIST

'Statistics' 카테고리의 다른 글

| 임상 개발 용어 (2) (0) | 2023.07.18 |

|---|---|

| 임상 개발 용어 (1) (0) | 2023.07.18 |

| 검정 방법 (0) | 2023.07.17 |

| 가설 검정 (Hypothesis Testing) (0) | 2023.07.17 |

| 가설 (Hypothesis) (0) | 2023.07.17 |