PReLU(Parametric Rectified Linear Unit)

leaky ReLU와 거의 유사한 형태를 보인다. leaky ReLU에서는 알파 값이 고정된 상수였다면 PReLU에서는 학습이 가능한 파라미터로 설정된다.

ThresholdReLU (Thresold Rectified Linear Unit)

ReLU와 거의 유사한 형태를 보이며 ReLU가 0 이하의 입력 값에 대해 0을 출력했다면 ThresoldReLU는 그 경계값을 설정할 수 있다. 1을 기본값으로 설정한다.

Softplus

ReLU 함수를 부드럽게 깎아놓은 형태를 취한다. 미분 함수가 sigmoid 함수가 된다.

Softmax

Softmax는 출력 값이 0~1 사이로 정규화되며, 모든 출력 값의 총합이 항상 1이 되는 특성을 가진 함수이다. softmax는 주로 ANN의 출력층에서 사용되며, 다중 클래스를 분류하는 목적으로 사용된다. 여러 개의 클래스에 대해 예측한 결과를 정규화하여 확률값으로 표현한다.

Softsign

tanh 함수와 거의 유사한 형태이다. tanh를 대체하기 위해 고안된 함수로 tanh 대신에 사용할 수 있다.

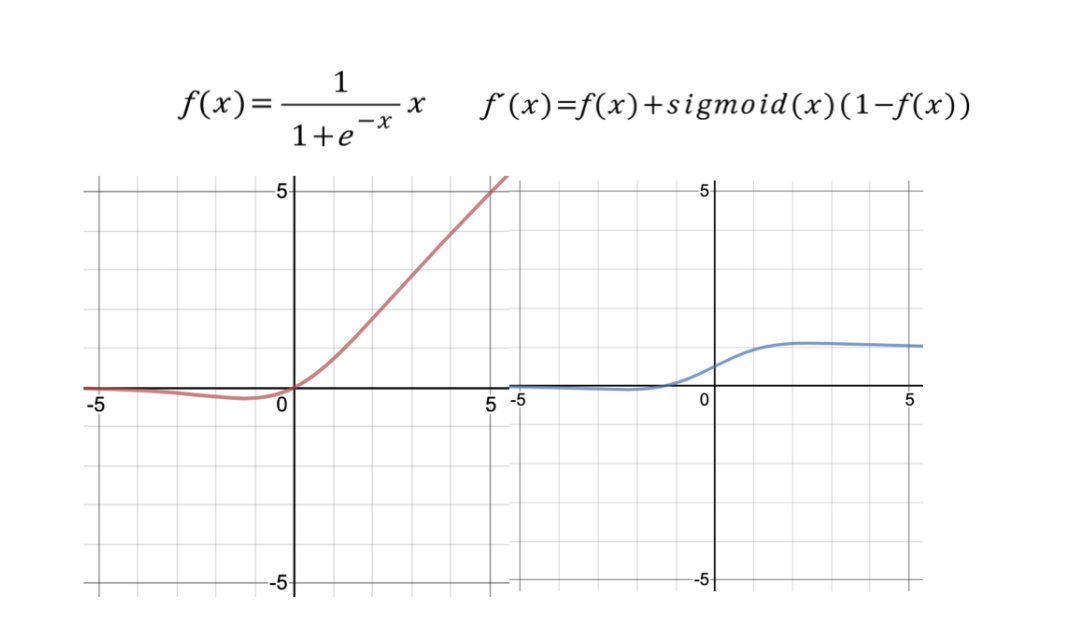

Swish

ReLU를 대체하기 위해 구글이 고안한 함수이다. sigmoid 함수에 x를 곱한 아주 간단한 형태이다. deep layer를 학습시킬 때 ReLU보다 더 뛰어난 성능을 가진다. CNN 아키텍쳐 가운데 하나인 mobilenet을 학습시키는데 사용된다.

갈아먹는 딥러닝 기초 [1] Activation Function(활성화 함수) 종류

들어가며 딥 러닝 기초 개념들을 복습하면서 관련 내용들을 정리해보려 합니다. 가장 먼저 각 활성화 함수별로 간단한 특징과 사용처 정도를 짚고 넘어가겠습니다. 자세한 개념들은 직접 검색

yeomko.tistory.com

'Learning-driven Methodology > DL (Deep Learning)' 카테고리의 다른 글

| [Deep Learning] 과적합 (Overfitting) (0) | 2022.01.03 |

|---|---|

| [Deep Learning] 척도 (Metrics) (0) | 2022.01.03 |

| [Deep Learning] 활성화 함수 (Activation Function) (1) (0) | 2022.01.03 |

| [Deep Learning] 손실 함수 (Loss function) (0) | 2022.01.03 |

| [Deep Learning] 비용 함수 (Cost Function) (0) | 2021.12.30 |