Llama 3

Meta는 8 및 70B 크기의 사전 학습 및 instruction 튜닝된 생성 텍스트 모델 모음인 Meta Llama 3 대규모 언어 모델 (LLM) 제품군을 개발하여 출시했다. instruction 튜닝된 Llama 3 모델은 대화 사용 사례에 최적화되어 있으며 일반적인 업계 벤치마크에서 사용 가능한 많은 오픈 소스 채팅 모델보다 성능이 뛰어나다. 입력 모델은 텍스트만 입력하고, 출력 모델은 텍스트와 코드만 생성한다.

Llama 3는 최적화된 트랜스포머 아키텍처를 사용하는 자동 회귀 언어 모델이다. 튜닝된 버전은 감독 미세 조정 (supervised fine-tuning, SFT)과 인간 피드백을 통한 강화 학습 (reinforcement learning with human feedback, RLHF)을 사용하여 유용성과 안전성에 대한 인간의 선호도에 맞춰 조정한다.

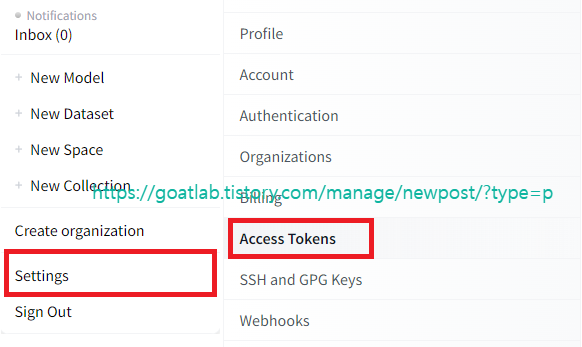

토큰 생성

Llama 3를 사용하기 위해 토큰 생성이 필요하다.

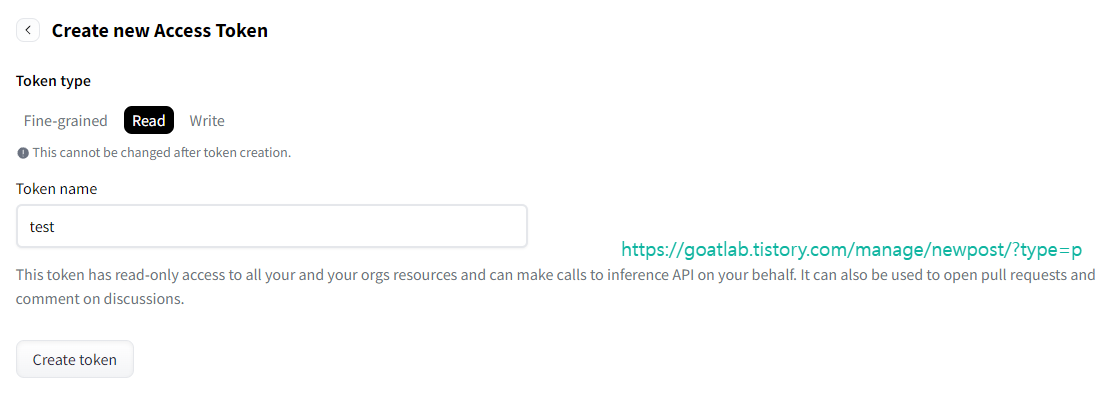

API 호출을 위해 Read로 유형을 선택한다.

토큰 키를 복사한다.

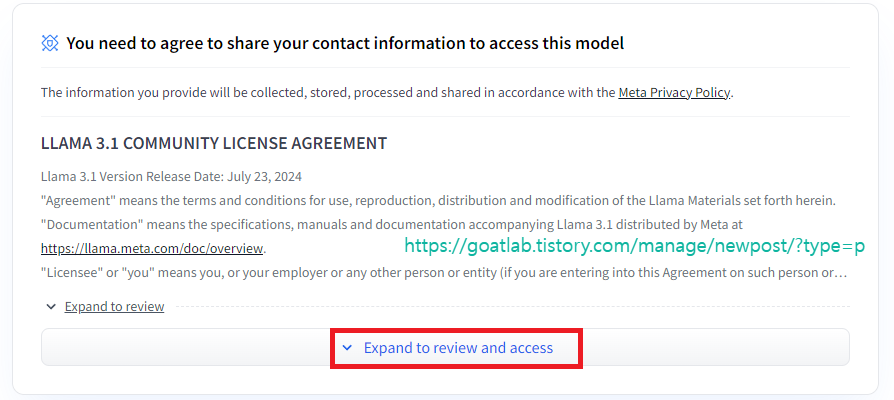

라이센스 동의

예제 코드

from huggingface_hub import login

login(token="hf_")from huggingface_hub import notebook_login

notebook_login() # 주피터에서 로그인from transformers import AutoTokenizer, pipeline

import transformers

import torch

model_id = "meta-llama/Meta-Llama-3-8B"

tokenizer = AutoTokenizer.from_pretrained(model_id)

pipeline = transformers.pipeline(

"text-generation",

model=model_id,

torch_dtype=torch.float32,

device_map="auto",

)

sequences = pipeline(

'I liked "Breaking Bad" and "Band of Brothers". Do you have any recommendations of other shows I might like?\n',

do_sample=True,

top_k=10,

num_return_sequences=1,

eos_token_id=tokenizer.eos_token_id,

max_length=200,

)

for seq in sequences:

print(f"Result: {seq['generated_text']}")

https://huggingface.co/meta-llama/Meta-Llama-3-8B

meta-llama/Meta-Llama-3-8B · Hugging Face

The information you provide will be collected, stored, processed and shared in accordance with the Meta Privacy Policy. META LLAMA 3 COMMUNITY LICENSE AGREEMENT Meta Llama 3 Version Release Date: April 18, 2024 "Agreement" means the terms and conditions fo

huggingface.co

'Linguistic Intelligence > LLM' 카테고리의 다른 글

| [LLM] PaliGemma Inference (0) | 2024.07.30 |

|---|---|

| [LLM] Instruction Tuning (0) | 2023.06.15 |

| 허깅페이스 (Hugging Face) (0) | 2023.05.09 |