728x90

반응형

SMALL

경사 하강법 (Gradient Descent)

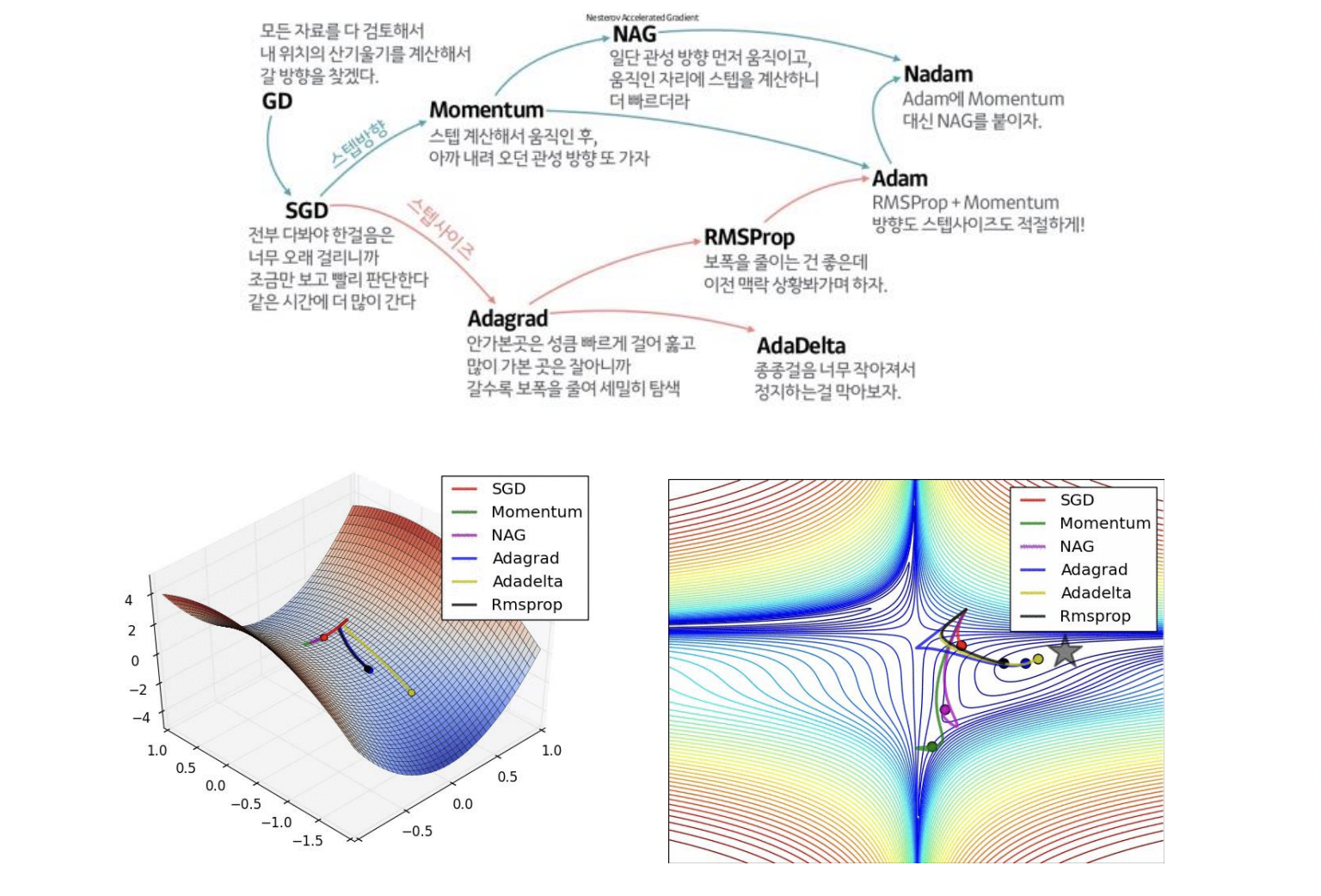

손실 함수의 최소값을 찾기 위한 알고리즘이다. 실생활에서 적용되는 데이터들은 함수 형태가 복잡하여 미분 계수를 계산하는 과정에 비해 비교적 쉽게 구현 가능하다. 데이터 양이 커질수록 계산량 측면에서 효율적이다.

|

학습률 (Learning rate)이 너무 크면 발산할 수 있고, 학습률이 너무 작으면 학습 시간이 오래 걸린다.

배치 사이즈 (Batch Size)

배치 사이즈는 기울기 업데이트시, 훈련 데이터셋을 묶어서 사용하는 정도를 나타낸다.

확률적 경사 하강법 (Stochastic Gradient Descent)

전체 훈련 데이터셋 중, 임의로 하나의 데이터를 선택하여 스탭을 진행한다. 방향이 매번 크게 바뀌므로 전역 최저점에 수렴하기 힘들지만 지역 최저점에 빠질 확률이 적다.

728x90

반응형

LIST

'Data-driven Methodology > DS (Data Science)' 카테고리의 다른 글

| [Data Science] 탐색적 데이터 분석 (Exploratory Data Analysis) (0) | 2023.07.17 |

|---|---|

| [Data Science] 모델 평가 (0) | 2022.11.29 |

| [Data Science] 손실 함수 (Loss Function) (0) | 2022.11.08 |

| [Data Science] 데이터 전처리 (0) | 2022.11.01 |

| [Data Science] folium을 활용한 지도 그리기 (0) | 2022.10.26 |