의사결정 트리 앙상블 (Decision Tree Ensembles)

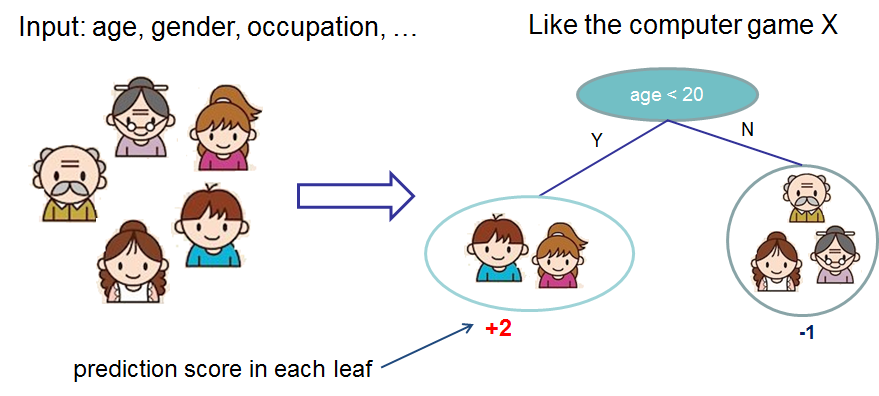

트리 앙상블 모델은 분류 및 회귀 트리 (CART) 세트로 구성된다. 다음은 누군가가 가상의 컴퓨터 게임 X를 좋아할지 여부를 분류하는 CART의 간단한 예이다.

가족 구성원을 다른 잎 (leaf)으로 분류하고 해당 잎에 점수를 할당한다. CART는 잎이 결정 값만 포함하는 결정 트리와 약간 다르다. CART에서 실제 점수는 각 리프와 연결되어 분류를 넘어 더 풍부한 해석을 제공한다. 이것은 또한 최적화에 대한 원칙적이고 통합된 접근 방식을 허용한다.

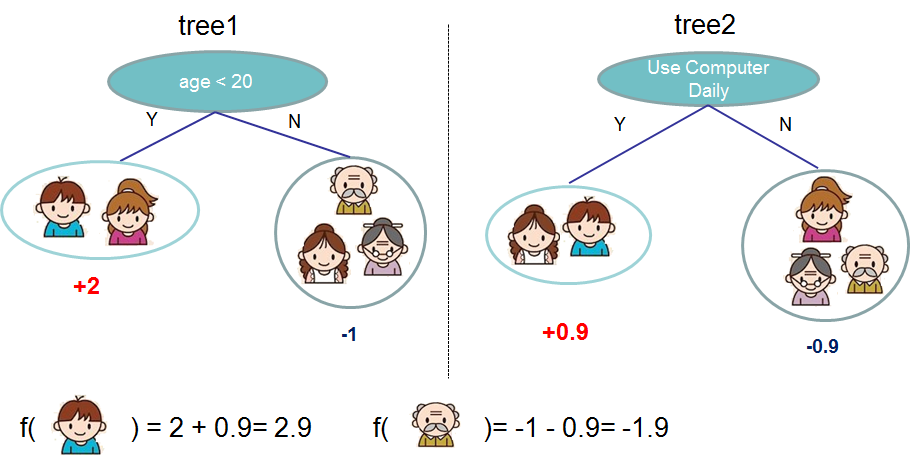

일반적으로 단일 트리는 실제로 사용하기에 충분히 강하지 않다. 실제로 사용되는 것은 여러 트리의 예측을 합산하는 앙상블 모델이다.

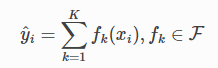

다음은 두 나무의 트리 앙상블의 예이다. 각 개별 트리의 예측 점수를 합산하여 최종 점수를 얻는다. 예를 보면 두 나무가 서로 를 보완 하려고 하는 것이 중요한 사실이다. 수학적으로 모델을 다음 형식으로 작성할 수 있다.

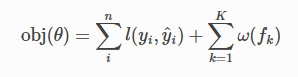

K는 나무의 수이고, 공간의 기능 fk이다. 그리고 F는 가능한 모든 CART의 집합이다. 최적화할 목적 함수는 다음과 같이 지정된다.

ω(fk)는 트리의 복잡성이다.

이제 여기에 트릭 질문이 있다. 랜덤 포레스트에서 사용되는 모델은 무엇일까? 트리 앙상블이다. 따라서, 랜덤 포레스트와 부스트 트리는 실제로 동일한 모델이다. 차이점은 그들을 훈련하는 방법에서 발생한다. 즉, 트리 앙상블에 대한 예측 서비스를 작성하는 경우 하나만 작성하면 되고 랜덤 포레스트와 그래디언트 부스트 트리 모두에서 작동해야 한다 (실제 예는 Treelite 를 참조.) 지도 학습의 요소가 흔들리는 이유에 대한 한 가지 예.

https://xgboost.readthedocs.io/en/stable/tutorials/model.html

Introduction to Boosted Trees — xgboost 1.6.0 documentation

XGBoost stands for “Extreme Gradient Boosting”, where the term “Gradient Boosting” originates from the paper Greedy Function Approximation: A Gradient Boosting Machine, by Friedman. The gradient boosted trees has been around for a while, and there

xgboost.readthedocs.io

'Learning-driven Methodology > ML (Machine Learning)' 카테고리의 다른 글

| [XGBoost] 트리 부스팅 (Tree Boosting) (2) (0) | 2022.05.06 |

|---|---|

| [XGBoost] 트리 부스팅 (Tree Boosting) (1) (0) | 2022.05.06 |

| [XGBoost] Boosted Trees (0) | 2022.05.06 |

| XGBoost (0) | 2022.05.03 |

| [Machine Learning] SHAP (SHapley Additive exPlanations) (0) | 2022.05.03 |