부스트 트리 (Boosted Trees)

XGBoost는 "Extreme Gradient Boosting"의 약자로, "그라디언트 부스팅"이라는 용어는 Friedman의 논문 Greedy Function Approximation: A Gradient Boosting Machine에서 유래했다.

지도 학습의 요소 (Elements of Supervised Learning)

XGBoost는 학습 데이터 (여러 기능 포함)를 사용하는 지도 학습 문제에 사용된다. xi는 목표 변수 yi를 예측하기 위함이다.

모델 및 매개변수 (Model and Parameters)

지도 학습의 모델은 일반적으로 예측의 수학적 구조를 나타낸다. 가중 입력 특성의 선형 조합. 예측 값은 작업, 즉 회귀 또는 분류에 따라 다르게 해석될 수 있다. 예를 들어, 로지스틱 회귀에서 positive class의 확률을 얻기 위해 로지스틱 변환될 수 있으며 출력의 순위를 매길 때 순위 점수로 사용할 수도 있다.

매개변수는 데이터에서 학습하는 미확정 부분이다. 선형 회귀 문제에서 매개변수는 θ 계수이다. 일반적으로 θ 매개변수를 나타내기 위함이다 (모델에는 많은 매개변수가 있으며 여기서 정의는 엉성함).

목적 함수: 훈련 손실 + 정규화 (Objective Function: Training Loss + Regularization)

모델을 훈련시키는 작업은 최상의 매개변수를 찾는 것과 같다. 훈련 데이터에 가장 잘 맞는 및 레이블, 모델을 훈련시키기 위해서는 모델이 훈련 데이터에 얼마나 잘 맞는지 측정하는 목적 함수를 정의해야 한다.

목적 함수의 두드러진 특징은 학습 손실과 정규화 (training loss and regularization)의 두 부분으로 구성된다는 것이다.

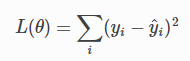

L은 훈련 손실 함수이고, Ω는 정규화 항이다. 훈련 손실은 훈련 데이터와 관련하여 모델이 얼마나 예측 가능한지를 측정합한. 일반적인 선택 L은 평균 제곱 오차이며 다음과 같이 지정된다.

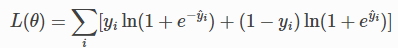

일반적으로 사용되는 또 다른 손실 함수는 로지스틱 회귀에 사용되는 로지스틱 손실이다.

정규화는 사람들이 일반적으로 추가하는 것을 잊어버린다. 정규화 항은 모델의 복잡성을 제어하여 과적합을 방지하는 데 도움된다. 이것은 다소 추상적일 수 있다. 다음 그림에서, 이미지의 왼쪽 상단 모서리에 있는 입력 데이터 포인트가 주어지면 시각적으로 단계 함수 를 맞추라는 메시지가 표시된다. 세 가지 중 어떤 솔루션이 가장 적합할까?

정답은 빨간색으로 표시된다. 이것이 시각적으로 귀하에게 합당한지 고려할 수 있다. 일반적인 원칙은 단순하고 예측 가능한 모델을 모두 원한다는 것이다. 둘 사이의 절충은 기계 학습에서 편향-분산 절충 (bias-variance tradeoff)이라고도 한다.

위에서 소개한 요소는 지도 학습의 기본 요소를 형성하며 머신 러닝 툴킷의 자연스러운 구성 요소이다. 예를 들어, 그래디언트 부스트 트리와 랜덤 포레스트 간의 차이점과 공통점을 설명할 수 있어야 한다. 공식화된 방식으로 프로세스를 이해하면 학습 목표와 가지치기 및 다듬기 (pruning and smoothing)와 같은 heuristics의 이유를 이해하는 데 도움된다.

https://xgboost.readthedocs.io/en/stable/tutorials/model.html

Introduction to Boosted Trees — xgboost 1.6.0 documentation

XGBoost stands for “Extreme Gradient Boosting”, where the term “Gradient Boosting” originates from the paper Greedy Function Approximation: A Gradient Boosting Machine, by Friedman. The gradient boosted trees has been around for a while, and there

xgboost.readthedocs.io

'Learning-driven Methodology > ML (Machine Learning)' 카테고리의 다른 글

| [XGBoost] 트리 부스팅 (Tree Boosting) (1) (0) | 2022.05.06 |

|---|---|

| [XGBoost] 의사결정 트리 앙상블 (Decision Tree Ensembles) (0) | 2022.05.06 |

| XGBoost (0) | 2022.05.03 |

| [Machine Learning] SHAP (SHapley Additive exPlanations) (0) | 2022.05.03 |

| [Machine Learning] MNIST (0) | 2022.04.28 |